-

Occupancy Network(점유 네트워크) 도입 배경과 작동 원리자율주행 2025. 4. 12. 10:57728x90SMALL

1) 기존 객체 분류 방식의 한계

• 차선·차량·보행자 등 사전에 정해진 클래스만 인식하는 방식은, 도로 위 예측 불가능한 물체(낙하물, 동물, 임시 구조물)를 놓칠 수 있다는 문제가 있었습니다.

• 테슬라는 이 문제를 해결하고자, 3D 점유(Occupancy) 개념을 도입해 “해당 공간이 비어 있는가?”를 우선적으로 파악하는 방식을 적용합니다.[6][7]

2) 작동 원리

• 카메라 여러 대로부터 얻은 영상을 3차원으로 재투영(Depth 추론)하고, 네트워크가 각 지점의 점유 확률을 계산합니다.

• 만약 어떤 영역이 “점유됨”으로 예측되면, 그 물체가 무엇이든 충돌 위험 대상이 됩니다.

• 이는 “UFO 낙하물” 같은 극단 상황에서도 즉각 회피가 가능하다는 논리적 근거를 제공합니다.

3) 장점과 한계

• 장점: 클래스 불문·노이즈에도 대응 가능, 범용성 높음.

• 한계: 여전히 카메라 성능이 저하되는 야간·폭우 등 특수 상황에선 오인식 가능성이 완전히 사라지지 않으며, 소프트웨어 업데이트로 지속 개선 중이라고 알려져 있습니다.[8]

- 왜 새로운 알고리즘이 필요한가?

• 카메라 기반(비전 기반) 자율주행은 LiDAR 센서가 없는 대신 카메라로 모든 것을 인식해야 함.

• 기존 “객체 검출(object detection)” 방식은 데이터셋에 없는 새로운 물체를 인식하기 어려움.

• 예시: 데이터셋에 없는 캥거루, 팔레트 등을 “알 수 없는 물체”로 인해 인식을 못해 사고로 이어지는 경우.

• 테슬라는 이를 개선하고자 “오큐펀시 네트워크(Occupancy Network)”를 개발.

- 오큐펀시 네트워크(Occupancy Networks)란?

• “로봇공학의 Occupancy Grid Mapping” 아이디어를 확장한 것.

• 3차원 공간을 작은 격자(‘Voxel’)로 나누어, 각 격자가 “비어있는지(Free)” “차 있는지(Occupied)”를 예측.

• 객체 검출에 의존하지 않고, 고정된 사각형(바운딩 박스) 대신 실제로 그 물체가 차지하는 공간을 3D로 표현 가능.

기존 방식(문제점)

1. Bird-Eye-View에만 국한 → 2D 평면에 표시

2. 고정된 사각형(바운딩 박스) → 트럭에 달린 사다리나 기기 같은 돌출부 처리 불가

3. 객체 검출 알고리즘 → 데이터셋에 없는 물체 인식 불가 (Ontology 문제)

오큐펀시 네트워크(개선점)

1. 2D가 아닌 3D 부피(Volumetric)로 공간을 표현

2. 사각형 대신 격자(3D Voxel)에 어느 부분이 점유되었는지 직접 예측

3. 데이터셋에 없는 물체라도 “차 있는 공간”으로 판단하여 충돌을 피할 수 있음

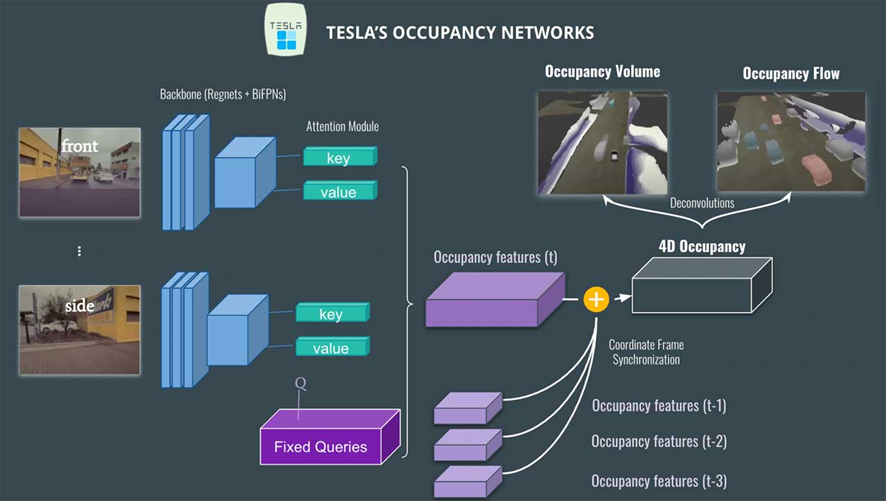

- 테슬라의 오큐펀시 네트워크 동작 흐름

여러 카메라(8개) 입력

• 전방, 후방, 측면 등 다양한 시야에서 들어오는 영상

특징 추출 (Feature Extraction)

• RegNet, BiFPN 같은 백본(backbone) 네트워크 사용

• 이미지에서 중요한 특징(Feature Map)을 추출

Attention 기반 Occupancy Detection

• 추출된 특징에 위치 정보 등을 활용하여 Attention 모듈 수행

• 예: “자동차 vs 아니냐?” “버스 vs 아니냐?” 같은 쿼리(Query), 키(Key), 밸류(Value)를 적용

• 그 결과, 점유도를 반영한 Occupancy Feature Volume(3D 특징 맵) 생성

과거 프레임 정보 결합 (4D Occupancy Grid)

• 이전 시점(t-1, t-2 …)의 Occupancy Volume과 현재 프레임의 Volume을 합쳐 시간 차원까지 고려

• 3D 격자에 시간이 더해져 “4D Occupancy Grid”가 됨

Deconvolution

• 원래 크기(해상도)로 복원하기 위해 Deconvolution(업샘플링) 과정을 거침

• 최종 출력:

• Occupancy Volume(3D 어느 곳이 차 있는지 예측)

• Occupancy Flow(물체가 어디로 움직이는지, 즉 3D Optical Flow 정보)

- Optical Flow vs Occupancy Flow

• Optical Flow: 전통적으로는 2D 영상에서 픽셀이 어떻게 이동하는지 계산 (화소 단위 속도 벡터)

• Occupancy Flow: 여기에 한 발 더 나아가, 3D 격자(각 Voxel)가 어떻게 움직이는지 추정

• 예: 빨간색(전진), 파란색(후진), 회색(정지) 등으로 표시

• 가려짐(occlusion) 문제 완화, 예측/계획 등에 유리

- NeRFs(Neural Radiance Fields) 활용

• 테슬라는 NeRF 기술을 이용해 “3D 재구성(3D Reconstruction)”을 수행

• 여러 시점에서 얻은 영상으로 3D 장면(건물, 구조물 등)을 복원

• 예: 여러 차량이 같은 건물을 찍으면 그 정보를 합쳐 더 정확한 3D 지도 생성

오큐펀시 네트워크가 만든 3D 결과와 NeRF로 복원한 3D 장면을 비교하여 오차 확인(검증)

• 블러, 비, 안개 같은 환경 문제를 “Fleet Averaging(차량들이 본 데이터를 평균화)”로 개선

요약하면

비전(카메라) 기반 자율주행의 한계

• 객체 검출 오류, 가려짐, 측정 거리의 불안정성, 데이터셋에 없는 물체 인식 불가 등

테슬라의 답: 오큐펀시 네트워크

• 3D 공간을 Voxels로 나누고, 각 셀이 비었는지/차 있는지 예측

• 기존 Bird-Eye-View와 바운딩 박스 기반 문제점을 해결

네트워크 흐름

• (1) 여러 카메라 입력 → (2) 특징 추출 → (3) Attention 모듈로 점유 볼륨 생성 → (4) 과거 볼륨과 시간축 결합 → (5) Deconv로 최종 Occupancy와 Flow 산출

Optical Flow & Occupancy Flow

• 물체가 어디로, 얼마나 움직이는지(3D 흐름)까지 알 수 있어 예측/계획 시 더 안전

NeRFs 적용

• 3D 재구성 기법과 대조하여 정확도 검증 및 지도 구축

• Fleet Averaging으로 환경 문제(안개, 비 등) 보완

미래 전망

• 테슬라 오토파일럿(완전 자율주행) 소프트웨어에 적용될 가능성이 큼

• 충돌 회피, 사각지대 최소화를 위한 핵심 기술로 주목

728x90'자율주행' 카테고리의 다른 글

FSD Planning (0) 2025.04.18 Interaction Search (0) 2025.04.15 하이드라넷(HydraNet)과 멀티헤드 아키텍처 (0) 2025.04.09 테슬라 FSD 기술 스택 깊이 파고들기: FSD 컴퓨터(HW3, HW4)와 SoC 내부 구조 (0) 2025.04.06 HD 맵 의존성 vs. 실시간 비전 의존성 (0) 2025.04.03