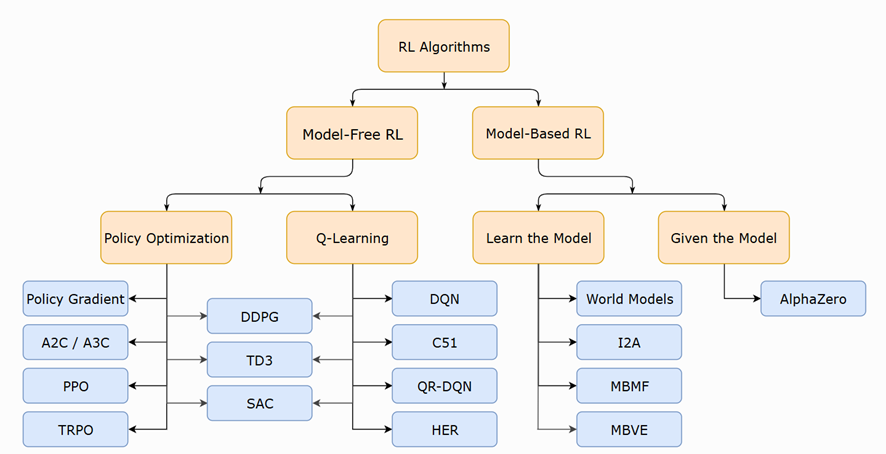

모델 프리(Model-Free) 강화학습과 모델 기반(Model-Based) 강화학습은 에이전트가 환경을 학습하는 방식의 큰 분기점입니다[spinningup.openai.com]. 모델 프리 RL에서는 에이전트가 환경의 모델(상태 전이나 보상에 대한 예측)을 명시적으로 학습하거나 사용하지 않고, 시행착오(trial-and-error)를 통해 정책을 직접 학습합니다. 반면 모델 기반 RL에서는 환경의 동작을 예측하는 모델을 활용하여 앞으로 일어날 일을 시뮬레이션 하거나 계획함으로써 결정할 행동을 학습합니다. 예를 들어, PPO(Proximal Policy Optimization)나 DDPG(Deep Deterministic Policy Gradient) 같은 알고리즘은 모델 없이도 환경에서의 경험 데이터만으로 최적 정책을 찾는 모델 프리 RL의 대표적인 사례이며, MBRL(Model-Based RL) 프레임워크나 World Models 같은 접근은 환경의 동적 모델을 학습하여 이를 활용하는 모델 기반 RL의 예시입니다.

모델 프리 RL의 장점은 구현과 튜닝이 상대적으로 간단하며, 모델링 오차에 신경 쓸 필요 없이 실제 경험 데이터로부터 직접 학습합니다. 최근까지도 모델 프리 방법들은 많은 영역에서 널리 적용되고 검증되어 왔습니다. 예를 들어, 로봇 제어 분야에서 PPO, DDPG 같은 모델 프리 알고리즘은 시뮬레이터 상에서 로봇의 걷기나 팔 제어 정책을 학습시키는 데 자주 활용됩니다.

Tesla의 사례로 보면, 자율주행 FSD(Full Self-Driving)나 휴머노이드 로봇 Optimus의 많은 부분에 인간 시연 데이터나 실제 주행 데이터로부터 학습한 네트워크를 사용하고 있는데, 이는 일종의 모델 프리 학습 결과를 활용하는 것입니다[newatlas.com]. 이러한 방식은 대용량의 실제 데이터를 통해 종단간 End-to-End로 행동을 학습시키는 Tesla의 전략과 맞물려 있으며, 별도의 명시적 환경 모델 없이도 방대한 주행 데이터에서 얻은 정책이 차량이나 로봇 제어에 활용되고 있습니다.

모델 프리 RL의 단점: 표본 효율성(sample efficiency)이 낮아 많은 경험 데이터가 필요하고, 복잡한 환경에서는 학습에 오랜 시간이 걸릴 수 있습니다. 또한 환경에 대한 내재적 이해 없이 행동을 학습하기 때문에, 학습되지 않은 새로운 상황에 대한 일반화가 어려울 수 있습니다. 특히 실제 로봇에 바로 적용하기에는 시행착오 과정에서의 물리적 위험이 있어, 안전한 시뮬레이션 환경이 필수적입니다.

예를 들어, Agility Robotics에서는 실제 이족보행 로봇 Digit의 보행 정책을 모델 프리 RL로 학습시키기 위해 NVIDIA Isaac 시뮬레이션을 사용하였는데, 수백만 회의 모터 토크 시퀀스를 가상으로 시도하고 나서야 넘어지지 않고 걷는 정책을 얻을 수 있었습니다. 이렇게 학습된 모델 프리 정책을 실제 로봇에 이전할 때는 시뮬레이션과 현실 간의 차이(sim2real 갭)를 극복해야 하는데, 시뮬레이터에 없는 미세한 현실 물리 현상이 문제를 일으키기도 합니다[agilityrobotics.com].

모델 기반 RL의 장점: 환경 모델을 활용하면 에이전트가 미리 보기(planning)를 통해 여러 가상 시나리오를 검토하고 최적의 행동을 선택할 수 있어 표본 효율성을 크게 높일 수 있습니다. 잘 작동할 경우, 적은 데이터로도 효과적인 정책을 얻을 수 있고, 모델을 통해 장기적인 결과를 고려한 계획을 세울 수 있습니다. 대표적인 예로, AlphaZero는 주어진 완벽한 게임 규칙 모델 안에서 스스로 시뮬레이션하며 학습하는 모델 기반 접근으로 뛰어난 성능을 보였습니다[spinningup.openai.com].

로봇 분야 연구에서도 모델 기반 기법을 적용한 사례가 늘고 있습니다. 구글 연구진은 실제 4족 보행 로봇에 모델 기반 RL을 적용하여, 5분 이내의 실제 데이터만으로도 보행 정책을 학습시키고 Model Predictive Control(MPC) 기법으로 안정적으로 로봇을 움직인 사례를 보고했습니다[research.google]. 이처럼 모델을 활용하면 매우 데이터 효율적인 학습이 가능하여, 장차 최소한의 실제 실험으로 로봇에게 새로운 행동을 가르치는 데 큰 잠재력이 있습니다.

모델 기반 RL의 단점: 정확한 환경 모델을 얻기가 어렵고, 모델에 작은 편향이나 오류가 있을 경우 에이전트가 이를 악용하거나 잘못된 방향으로 학습할 위험이 있습니다. 학습된 모델은 실제 환경을 완벽히 재현하지 못할 수 있으며, 그 결과 모델 상에서 최적인 정책이 실제 환경에서는 성능이 저하되거나 실패하는 경우가 발생합니다. 또한 모델 학습 자체가 복잡한 최적화 문제여서, 높은 계산 자원이 필요하고 구현이 어려울 수 있습니다.

이러한 이유로 2010년대까지는 모델 프리 방법이 더 널리 연구되고 사용되었으나, 최근에는 딥 러닝을 활용한 모델 러닝 발전으로 모델 기반 접근도 다시 주목받고 있습니다. 예를 들어, World Models 연구에서는 에이전트가 자신의 꿈속에서 학습하듯이, 실제 환경을 본뜬 생성 모델 안에서 정책을 훈련하고 이를 실제로 이식하는 아이디어를 선보였습니다[worldmodels.github.io]. 이는 모델 기반 RL이 충분히 정확한 세계모델만 있다면 현실을 대체하여 학습이 가능함을 보여준 흥미로운 사례입니다.

Tesla FSD, Optimus, NVIDIA Cosmos를 사례로 양측 접근을 비교해보면 흥미로운 대조가 드러납니다. Tesla의 자율주행 FSD는 전통적 의미의 강화학습과는 다소 차이가 있지만, 신경망 비전 모델로부터 차량의 주행 경로를 예측하고 플래닝하는 과정에서 환경에 대한 암묵적 모델을 활용한다고 볼 수 있습니다. Tesla는 자율주행을 위해 도로 주변의 객체들과 지형을 실시간으로 인식하여 벡터 공간으로 표현하고 미래 움직임을 예측하는 모듈을 갖추고 있는데, 이는 일종의 월드 모델(world model)을 구성하는 것이라 할 수 있습니다.

이 예측 모델 위에서 차량의 최적 경로를 계획하는 것은 환경 모델을 활용한 모델 기반 의사결정 요소를 포함합니다. 반면, 최종 제어 정책 자체는 방대한 주행 데이터로 훈련된 End-to-End 신경망에 의해 산출되므로, 순수한 RL이라기보다는 모델 프리한 정책 학습 결과(혹은 모방학습)를 사용하는 측면이 큽니다. 즉 Tesla FSD는 모델 기반적인 세계 이해와 모델 프리적인 정책 실행이 결합된 혼합 양상을 보입니다.

Tesla의 휴머노이드 로봇 Optimus도 유사한 접근을 취하고 있습니다. Optimus의 두뇌는 Tesla Autopilot과 동일한 비전 기반 AI 기술을 재훈련해 활용하고 있는데, 주변 환경을 카메라로 인지하고 객체를 식별하는 부분은 자율주행에서 활용된 강력한 신경망 모델을 그대로 사용합니다[notateslaapp.com].

이 로봇은 새로운 작업을 배우기 위해 인간 시연 데이터를 활용하는데, 인간이 모션캡처 슈트를 입고 작업하는 모습을 가상 로봇 모델이 따라 하며 움직임 패턴을 학습하고 있습니다. 이런 모방 학습 기반의 접근은 별도의 물리 모델 없이 직접 정책을 배우는 모델 프리 RL의 맥락에 있습니다. 동시에, Optimus는 Autopilot으로부터 물려받은 실시간 환경 맵 구성 능력을 통해 주변을 이해하고 계획을 수립하므로, 이는 환경 모델을 활용한 모델 기반 요소라고 볼 수 있습니다. 요컨대 Tesla의 로봇 학습은 대량의 실제 데이터와 강력한 비전 신경망을 바탕으로, 필요시 시뮬레이션이나 모델 활용을 보조적으로 동원하는 실용적인 접근이라 할 수 있습니다.

이에 반해 NVIDIA의 Cosmos 프로젝트는 보다 전형적인 모델 기반 강화학습 철학을 띠고 있습니다. Cosmos는 현실 세계의 동영상을 무려 2천만 시간 이상 학습하여 물리적으로 그럴듯한 세계 모델(foundation model)을 만들어냈습니다 .

이는 마치 거대한 시뮬레이터와 같아서, 이 모델을 통해 창고에서 상자가 떨어지는 영상과 같은 장면을 포토리얼리틱하게 생성할 수 있고, 이를 로봇 학습 데이터로 활용합니다 . 다시 말해, NVIDIA Cosmos는 생성형 AI를 이용해 현실과 유사한 가상 환경을 마음대로 만들어내고, 로봇이 그 안에서 학습하도록 돕는 플랫폼입니다.

이러한 접근은 에이전트가 학습할 환경을 모델이 제공해주는 것이므로, 모델 기반 RL의 한 형태로 볼 수 있습니다. 로봇은 Cosmos가 만들어낸 비디오 시뮬레이션을 보며 세상을 예측하고 학습하게 되므로, 현실 대신 모델 세계에서 경험을 쌓는 셈입니다. Cosmos처럼 거대한 세계 모델을 준비하는 데는 많은 노력이 들지만, 일단 준비되면 로봇에게 필요한 다양한 상황을 무한히 생성해줄 수 있다는 장점이 있습니다[nvidianews.nvidia.com].

NVIDIA의 새로운 로봇인식 모델들은 Cosmos로부터 생성된 데이터를 활용해 훈련되고 있으며, Agility Robotics, Figure AI 등 여러 로봇 기업들이 이 플랫폼을 채택하여 실제 데이터 수집 비용을 줄이면서 로봇 AI를 개발하고 있습니다.

정리하면, 모델 프리 RL은 현실 또는 시뮬레이션에서 얻은 데이터로 직접 정책을 학습하기 때문에 구현이 단순하고 현재 로봇 제어에 널리 사용되고 있지만, 많은 데이터가 필요하고 학습 효율이 낮은 단점이 있습니다. 모델 기반 RL은 환경 모델을 통해 계획과 예측을 활용함으로써 적은 데이터로도 학습이 가능하고 복잡한 문제에 대한 장기 전략 수립에 유리하지만, 정확한 모델 확보의 어려움과 높은 복잡도로 인해 적용이 쉽지 않았습니다.

실제 로봇 AI에는 두 접근을 절충하는 방향이 유망한데, 예를 들어 시뮬레이터나 세계 모델을 활용해 안전하게 학습(모델 기반 장점)하고 최종 정책은 신경망으로 실행(모델 프리 활용)하는 식입니다. Tesla와 NVIDIA의 사례에서도 볼 수 있듯이, 현실 데이터와 가상 모델을 조합하여 효율과 성능을 모두 추구하는 것이 로봇 강화학습의 실제 적용 방향이라고 할 수 있습니다. Tesla는 방대한 실제 주행/작업 데이터 자산을 바탕으로 한쪽 극단을 대표하고, NVIDIA는 물리 시뮬레이션과 생성모델을 통한 데이터 생산으로 다른 한쪽 극단을 개척하고 있어, 두 회사의 행보는 향후 로봇 학습 전략의 가능성을 잘 보여주는 사례입니다.

'Humanoid' 카테고리의 다른 글

| 테슬라와 NVIDIA의 강화학습 전략 비교 (0) | 2025.05.02 |

|---|---|

| 계층적 강화학습(HRL) 적용 사례 (0) | 2025.04.29 |

| 로봇 인식 및 행동 모델링 접근법 차이 (0) | 2025.04.23 |

| 강화학습 적용 방식과 시뮬레이션 환경 비교 (0) | 2025.04.20 |

| Optimus vs. Cosmos 기반 로봇 개발 비교:데이터 수집 및 합성 데이터 활용 (0) | 2025.04.16 |